发布时间:2023-10-30

光计算以光子而非电子作为信息载体,以其高信息容量、低功耗、光速处理和大规模并行等特点,被广泛认为是后摩尔时代的颠覆性计算技术。人们致力于通过对光波的(振幅、相位、偏振和频率等)调控来构建光学神经计算架构,有望在机器视觉、智能驾驶、智慧医疗和万物互联等领域取得重要应用。

由于传统衍射光学元件的调控维度有限,目前的光衍射神经网络更多依靠光的相位调制进行功能设计,没有实现全傅里叶参量(即光复振幅)的任意且独立调控,而复振幅又是光网络需要训练和学习的完整参数。

超表面,由平面亚波长结构单元构成,几乎可以塑造任意的光波前。尽管超表面具有优异的光波调控能力,但现有超表面复振幅调控方案又会带来网络神经元密度降低或偏振转化复杂等问题。因而如何设计高效、完全解耦、大空间密度、简单偏振转换的复振幅调控超表面单元来搭建高性能的衍射光神经网络架构,仍然具有较大的挑战性。

鉴于此,金莎娱乐app下载官网王占山教授和程鑫彬教授团队,联合湖南大学 段辉高教授团队,利用双折射和偏振旋转设计原理实现了对振幅和相位独立且任意调控的介质超表面单元,并基于此实现了一种全傅里叶参量的光学超表面衍射神经网络(FONM),阐明了该架构相比传统的纯相位型光学衍射神经网络在典型功能和场景下更具有优势。近日,相关研究成果“Full-Fourier-Component Tailorable Optical Neural Meta-Transformer”发表在Wiley旗下期刊《激光与光子学评论》(Laser & Photonics Reviews)上。文章通过仿真和实验证明了:其作为分类器,FONM提高了识别精度,特别是对于高频特征较多的输入;作为成像仪,它可以有效抑制输出图像的背景噪声;作为编码器时,还可以同时实现近场灰度纳米打印和神经全息的功能复用。

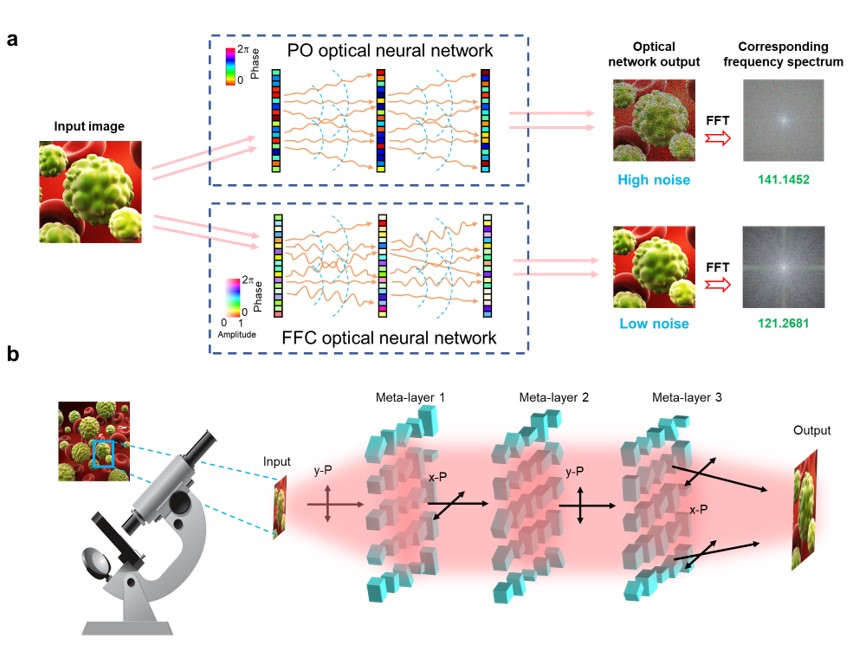

论文首先对比了传统的衍射神经网络和FONM架构,如图1a所示,前者通过纯相位(PO)调控来操纵衍射光场,因此网络的输出结果具有更多的高频成分,且不可避免地受到环境噪声影响。相比之下,FONM旨在操纵光场的全傅里叶分量,可以提高成像质量等性能,其架构原理图如图1b所示。

图1 (a)纯相位光网络和FONM对比,(b)三维架构FONM成像仪

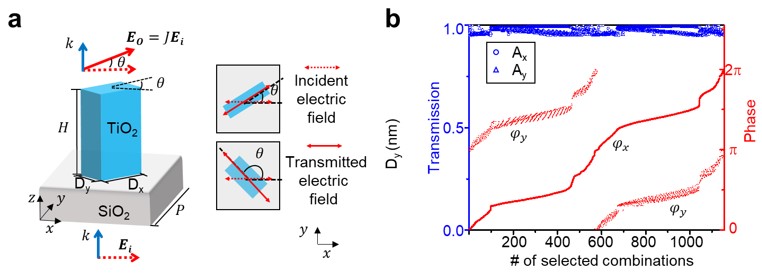

为了在FONM中实现任意且独立的振幅和相位调制,文章采用矩形双折射纳米柱结构,如图2a所示。在x偏振光入射和y偏振光出射时,满足振幅匹配![]() 和相位差匹配

和相位差匹配![]() ,匹配结果如图2b所示,此时光通过超表面的输出可以简化为

,匹配结果如图2b所示,此时光通过超表面的输出可以简化为![]() ,此时振幅和相位可以分别由θ和φx独立且任意地调控。

,此时振幅和相位可以分别由θ和φx独立且任意地调控。

图2 (a)超表面神经元的结构和工作偏振态,(b)振幅、相位匹配条件

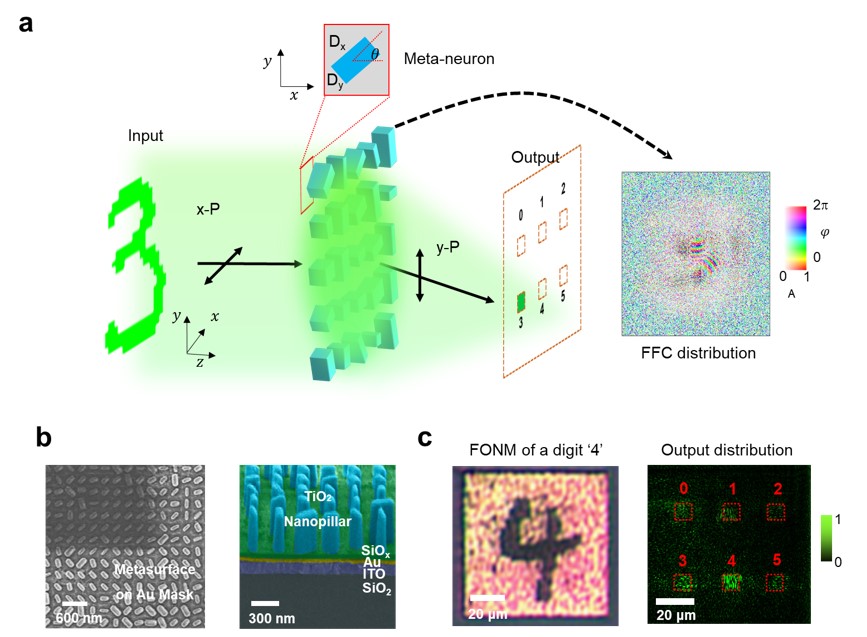

作为概念验证,首先将FONM设计为一个分类器,可以识别0到5的手写数字,如图3a所示。该器件是通过电子束直写和原子层沉积工艺制作完成,其顶视和剖视SEM结果如图3b所示。以数字“4”的输入为例,测试了网络的输出,如图3c所示,结果表明最大的光强被聚焦在对应的正确区域,识别是成功的。

图3 (a)手写数字的FONM分类器示意图,(b)FONM器件的SEM图,(c)FONM测试的网络输出

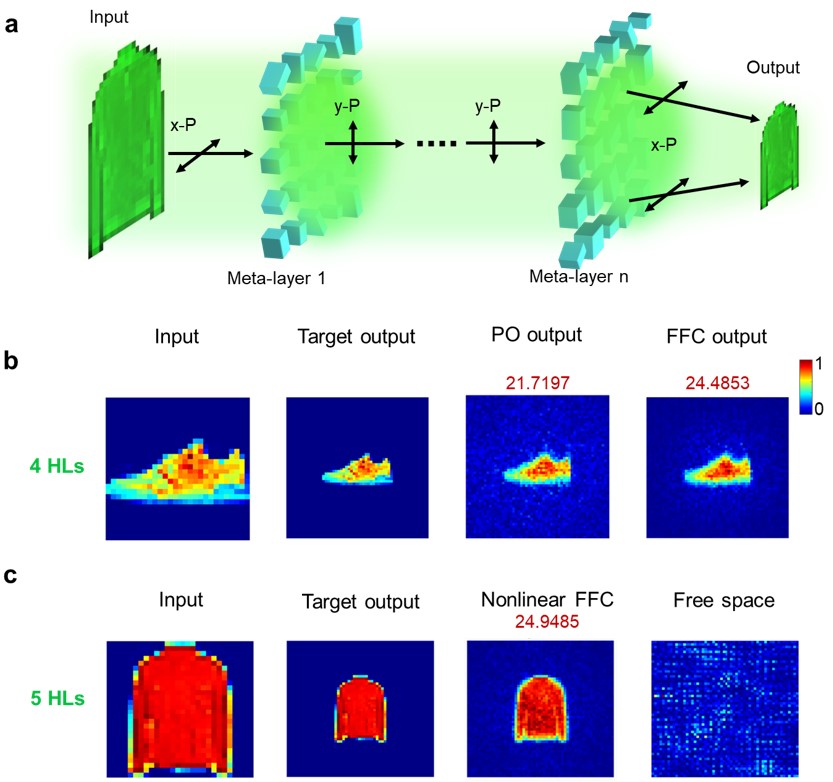

此外,还展示了其处理另一类复杂问题(回归问题)的能力,将提出的FONM架构应用于压缩成像(图4a),并且将其与纯相位网络进行对比(图4b)。发现FONM的输出图像具有更高的峰值信噪比和较低的背景噪声,因而带来更优的成像质量。而且该架构还可以与光学非线性集成提高网络的完整性并进一步提高性能,如图4c所示。

图4 (a)FONM压缩成像仪示意图,(b)FONM与纯相位网络的成像对比,(c)FONM集成非线性的结果

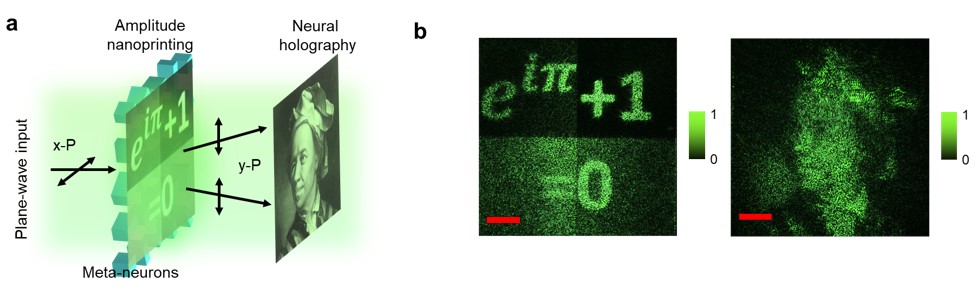

进一步,将FONM作为一个编码器分别编码振幅和相位剖面,以生成两幅图像,并通过近场的纳米打印和远场的神经全息展示,如图5a所示。其实验结果(5b)与仿真非常好的吻合。

图5 (a)FONM编码器示意图,(b)实验的纳米打印和神经全息

该工作设计并实验展示了基于超表面的全傅里叶参量光学衍射神经网络,证明了其执行三种基本类型任务的能力,即加密、分类和回归。结果表明,与纯相位型网络相比,该架构具有更好或更多的功能,为全参量光网络提供了一种方案,可以扩展到许多光学应用,包括机器视觉、信息安全等。

同济大学博士后董思禹、湖南大学胡跃强副教授、湖南大学段辉高教授、同济大学程鑫彬教授为论文共同通讯作者,同济大学博士生罗栩豪和博士后董思禹为论文共同第一作者。对论文具有突出贡献的合作者还包括同济大学魏泽勇副教授和王占山教授。该研究工作得到了国家自然科学基金委员会、上海市教育委员会、上海市科学技术委员会、湖南省自然科学基金、中国博士后科学基金会等项目的支持。